Microsoft пропонує дистильовані моделі DeepSeek R1 для ПК Copilot+

DeepSeek підкорив мобільний світ і тепер розширює свою присутність на Windows - на диво, за повної підтримки Microsoft. Вчора софтверний гігант додав модель DeepSeek R1 до своєї платформи Azure AI Foundry, щоб дозволити розробникам тестувати та створювати хмарні додатки та сервіси з її допомогою. Сьогодні Microsoft оголосила, що пропонує дистильовані версії R1 для комп'ютерів Copilot+.

Спочатку дистильовані моделі будуть доступні для пристроїв на базі чіпів Snapdragon X, процесорів Intel Core Ultra 200V, а потім для ПК на базі AMD Ryzen AI 9.

Першою моделлю буде DeepSeek-R1-Distill-Qwen-1.5B (тобто модель з 1,5 мільярдами параметрів), а незабаром з'являться більші та потужніші моделі 7B та 14B. Вони будуть доступні для завантаження з Microsoft AI Toolkit.

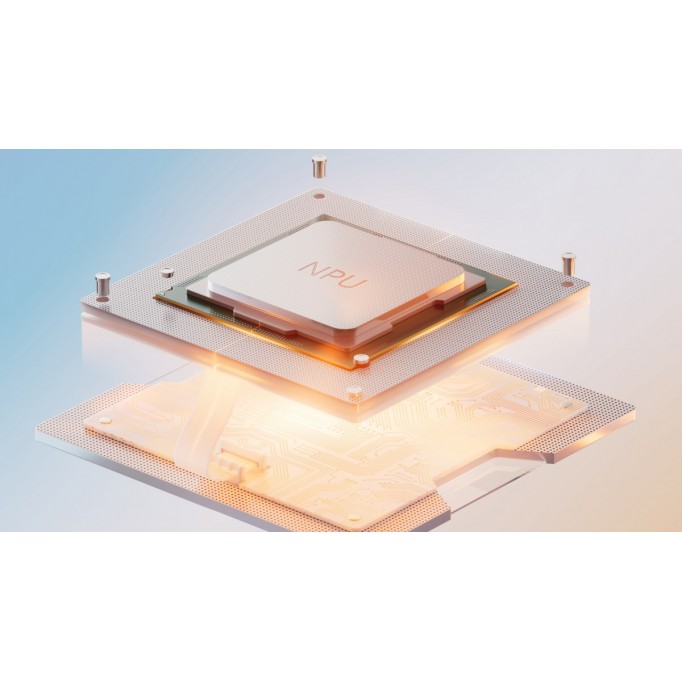

Microsoft довелося доопрацювати ці моделі, щоб оптимізувати їх для роботи на пристроях з NPU. Операції, які значною мірою покладаються на доступ до пам'яті, виконуються на центральному процесорі, в той час як операції з інтенсивними обчисленнями, такі як трансформаторний блок, виконуються на NPU. Завдяки оптимізації Microsoft вдалося досягти швидкого часу до першого токена (130 мс) і пропускної здатності 16 токенів в секунду для коротких підказок (до 64 токенів). Зверніть увагу, що «токен» схожий на голосну (важливо, що один токен зазвичай має довжину більше одного символу).

Microsoft є сильним прихильником і глибоко інвестує в OpenAI (розробники ChatGPT і GPT-4o), але, схоже, вона не грає в улюбленців - на її Azure Playground є моделі GPT (OpenAI), Llama (Meta), Mistral (компанія, що займається ШІ), а тепер і DeepSeek теж.

У будь-якому випадку, якщо вам більше подобається локальний ШІ, спочатку завантажте AI Toolkit для VS Code. Звідти ви зможете завантажити модель локально (наприклад, «deepseek_r1_1_5» - це модель 1.5B). Нарешті, натисніть кнопку Спробувати в Playground і подивіться, наскільки розумна ця дистильована версія R1.

«Дистиляція моделі», яку іноді називають “дистиляцією знань”, - це процес взяття великої моделі ШІ (повна версія DeepSeek R1 має 671 мільярд параметрів) і перенесення якомога більшої кількості її знань на меншу модель (наприклад, 1,5 мільярда параметрів). Це не ідеальний процес, і зменшена модель має менші можливості, ніж повна модель, але її менший розмір дозволяє їй працювати безпосередньо на споживчому обладнанні (замість спеціального апаратного забезпечення для ШІ, яке коштує десятки тисяч доларів).